Por Ray Kurzweil1Artículo original aparecido en la revista angloparlante New Scientist en el número correspondiente al 24 de Septiembre del 2005, y reimpreso en la revista alemana Spektrum der Wissenschaft en Enero del 2006. La traducción del artículo en alemán, así como los enlaces y el subrayado, son mios.

Si el gurú de la tecnología Ray Kurzweil tiene razón, en tan solo veinte años habrá computadoras no solo pensantes, sino aún más inteligentes que el hombre. En el siguiente ensayo, Kurzweil extiende su pronóstico a la genética y a la biotecnología.

En el año 2003, y con motivo del 50mo. aniversario del descubrimiento de la estructura del ARN (descubrimiento realizado por los biólogos James Watson y Francis Crick), la revista TIME organizó la conferencia The future of Life. A todos los ponentes (también a mí) se nos preguntó que nos depararían los próximos cincuenta años: la mayoría de los pronósticos evidenciaron una gran miopía. James Watson predijo que en cincuenta años existirán medicamentos con la ayuda de los cuales podremos comer todo lo que queramos sin aumentar de peso. „¿Cincuenta años?“ – pregunté estupefacto, pues me pareció demasiado pesimista: de hecho, ya lo hemos logrado con ratones; y basados en esa investigación, ya estamos desarrollando ese tipo de medicamentos para seres humanos, que aparecerán en el mercado en los próximos cinco a diez años, no en cincuenta.

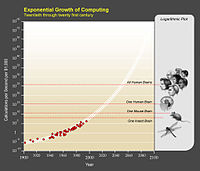

El error cometido por Watson (y por casi todos en aquella conferencia) fue pensar que la velocidad de la evolución es constante y que el progreso del siglo que viene se producirá a la misma velocidad que el progreso de los últimos cincuenta años. A esta forma de ver el futuro yo la denomino „intuición lineal“: la gente supone intuitivamente que la velocidad actual del progreso se mantendrá en el futuro.

Sin embargo, basta con conocer un poco de historia de la tecnología para darse cuenta que los cambios tecnológicos se producen de forma exponencial, no lineal. Podemos estudiar los datos de diferente manera, durante diferentes períodos de tiempo y dentro de un amplio espectro de tecnologías, desde la electrónica hasta la biología. Podemos analizar las consecuencias del progreso, que van desde la suma del conocimiento humano hasta el conjunto de la economía; hagamos lo que hagamos, siempre descubriremos una aceleración exponencial de crecimiento y progreso.

Entender ese progreso exponencial es la llave para entender la evolución futura. A largo plazo, el crecimiento exponencial produce modificaciones de dimensiones dramáticamente diferentes a las que produce el crecimiento lineal. Por ejemplo, hasta 1990 el éxito del Proyecto Genoma Humano (dedicado a descifrar el material genético del ser humano) era muy controvertido; en 1989 habíamos secuenciado una milésima parte del genoma. Pero a partir de 1990, la cantidad de datos secuenciados se duplicó año tras año (con una tasa de aumento que se mantiene hasta hoy), y para el 2003 el genoma humano estaba completamente descifrado.

Todas las tecnologías de la información evolucionan de manera exponencial. Además, practicamente todas las tecnologías se convierten, en algún momento, en tecnologías de la información. Combinando estas tendencias podemos predecir de manera más o menos fiable que en un futuro no muy lejano habremos alcanzado la Singularidad, o sea: el momento en donde los cambios tecnológicos se sucederán tan velozmente y sus consecuencias serán tan profundas, que modificarán la vida de los seres humanos de manera irrevocable. Estaremos en condiciones de reprogramar nuestra biología y, finalmente, de trascenderla. El resultado será la fusión profunda entre nosotros y nuestra tecnología.

Un nuevo paradigma por década.

Los indicios del omnipresente crecimiento exponencial se encuentran por doquier. En mi libro „The Singularity is Near“ presenté cuarenta gráficos que abarcan una gran cantidad de ámbitos (por ejemplo internet, escáners cerebrales o biotecnología), en cada uno de los cuales se evidencia un crecimiento exponencial. En general, mis modelos muestran que duplicamos la tasa del cambio de paradigma (comparable a grosso modo con la tasa de innovación técnica) cada diez años. Durante todo el siglo XX, la velocidad del progreso ha ido en constante aumento. Para el año 2000 el aumento fue sido tal, que podríamos lograr tantas innovaciones como la suma de todas las que se produjeron en el siglo XX, en tan solo veinte años.

La tecnología de la información crece a una velocidad vertiginosa. Si medimos la relación precio-desempeño, ancho de banda, cantidad de memoria, casi duplicamos su potencia, año tras año. Eso equivale a un factor de mil en diez años, de un millón en veinte años, de mil millones en treinta años. Así, el crecimiento exponencial conduce a mejoras del orden de los mil millones en poco más de un cuarto de siglo.

El crecimiento exponencial de la informática ya lleva más de un siglo y se produjo, fundamentalmente, en cinco grandes pasos:

1. La técnica electromecánica de cálculo, utilizada por primera vez en el censo norteamericano de 1890

2. Ordenadores de relés, que a principios de los años ’40 pudieron descifrar el código militar nazi

3. En 1952, la CBS utilizó ordenadores a válvulas de vacío para realizar pronósticos electorales en los comicios ganados por Dwight Eisenhower

4. A comienzos de los años ’60, los primeros viajes espaciales fueron realizados con la ayuda deordenadores a transistores

5. Por último, en 1958 se inventó el circuito integrado (chip o microchip), que dio lugar a los primeros ordenadores fabricados en serie, a fines de la década del ’60.

Cada uno de estos cambios de paradigma hizo que la tecnología anterior perdiera fuerza, lo que obligó a los investigadores a desarrollar la siguiente generación. Hoy nos encontramos frente a (por lo menos) una década más, dominada por el paradigma „miniaturización de transistores en circuitos integrados“; sin embargo, ya existen enormes avances en el desarrollo del sexto paradigma de la informática, que nos será brindado por ordenadores moleculares paralelos: por ejemplo, nanotubos de carbono. Y la electrónica es solo un ejemplo entre muchos. Otro: necesitamos catorce años para secuenciar el genoma del virus HIV; el del SARS fue descifrado en solo treinta y un días.

Todo ello permite afirmar que podemos predecir algunas variables características, como la relación precio-desempeño o la potencia de un gran número de tecnologías de la información. Por supuesto, también hay cosas que no podemos predecir con exactitud. De hecho, en muchos proyectos especiales se evidencia nuestra incapacidad para realizar predicciones exactas. Sin embargo, la potencia general de las tecnologías de la información puede ser pronosticada en todas las áreas; y no digo esto sin fundamento: hace más de veinte años que realizo este tipo de predicciones a futuro.

Existen ejemplos de otras áreas del conocimiento humano en donde también podemos predecir resultados generales partiendo de un conjunto de sucesos impredecibles. Por ejemplo, resulta imposible calcular la trayectoria que tomará una molécula cualquiera dentro de un gas; y sin embargo, podemos predecir el comportamiento del gas en su conjunto pues conocemos las leyes de la termodinámica, aunque ese gas esté compuesto por innumerables moléculas que interactúan caóticamente entre sí. De forma análoga, no es posible conocer los resultados de un proyecto o emprendimiento específicos; pero sí puede predecirse el resultado global de la tecnología de la información (compuesta por incontables actividades que se comportan de manera caótica), mediante un método que he denominado Ley de Rendimientos Acelerados

¿Qué nos dice la Ley de Rendimientos Acelerados sobre el futuro? Según la velocidad de cambio de paradigma nombrada más arriba, entre el año 2000 y el 2014 vamos a sufrir una evolución equivalente a veinte años de evolución de acuerdo a la velocidad del año 2000. O (lo que es lo mismo) al equivalente evolutivo de todo el siglo XX. Luego del año 2014, conseguiremos la misma tasa evolutiva pero solo en siete años. Para expresarlo de otro modo: durante el siglo XXI no tendremos cien años de evolución tecnológica, sino que (basándonos en la velocidad evolutiva del año 2000) evolucionaremos tanto como en los dos mil años anteriores. Eso equivale más o menos a mil veces la evolución que logramos en el siglo XX.

¿Límites del crecimiento exponencial?

La tecnología de la información, sobre todas las cosas, crecerá irrefrenablemente. Y ahí es donde debemos prestar atención; al fin y al cabo, todo lo que tiene algún valor se transformará en tecnología de la información: nuestra biología, pensamientos y procesos mentales, nuestras fábricas y mucho más. Así, por ejemplo, procesos computarizados basados en la nanotecnología nos permitirán producir productos complejos, en un nivel molecular. Como consecuencia, hacia el año 2025 podremos satisfacer nuestra demanda de energía con paneles solares muy baratos, construidos con nanotecnología, los que aprovecharán un 0,03 por ciento de la luz solar que recibe nuestro planeta, lo que alcanzará holgadamente para cubrir la demanda prevista para esa época.

Una objeción común dice que también en un crecimiento exponencial existen límites; por ejemplo, los conejos en Australia. La respuesta es: sí, esos límites existen, pero no son demasiado limitantes. En el 2020 se podrán comprar ordenadores con una potencia de 1016 FLOPS a mil dólares (los ordenadores actuales alcanzan aproximadamente los 109 FLOPS). Según mis cálculos, ese es el valor necesario para la simulación del cerebro humano; y algunos años más adelante ya podremos construir ordenadores aún mejores: circuitos de nanotubos de una pulgada cúbica (aproximadamente dieciseis centímetros cúbicos) serán alrededor de cien millones de veces más potentes que un cerebro humano.

La última generación de ordenadores que creo que surgirán hacia finales de este siglo pesarán un kilogramo (más o menos lo mismo que los Laptops actuales) y alcanzarán los 1042 FLOPS, aproximadamente diez trillones (1016) de veces más que todos los cerebros humanos juntos. Y eso solo si limitamos a los ordenadores a trabajar a bajas temperaturas; si encontráramos un método que nos permita usarlas y dejar que su temperatura se eleve, podríamos aumentar su potencia en un factor de cien millones más. Y por supuesto, utilizaremos más que un kilogramo para construirlas. Al final, gran parte de la materia y energía de nuestro alrededor será utilizada como sustrato de ordenadores.

Nuestro dominio sobre los procesos de la información, cada vez más preciso, conducirá a que el siglo XXI esté marcado por tres grandes revoluciones tecnológicas: en este momento nos encontramos en la fase temprana de la „Revolución G“ („G“, por „Genética y Biotecnología“). La biotecnología nos brinda la oportunidad de modificar ciertos genes específicos, no solo para algunos aislados bebés de diseño; sino más bien para generaciones enteras de Baby-Boomers.

Hoy mismo existen tecnologías mediante las cuales pueden suprimirse ciertos genes espefcificos, como por ejemplo la Ribointerferencia (o RNAi, por sus siglas en inglés). Esto sucede al impedir que un ARN-Mensajero situado en un gen específico transmita las instrucciones de montaje a la proteína en cuestión. Cada gen humano es, simplemente, uno de alrededor de veintitrés mil pequeños programas de software que representan el „diseño“ de nuestra biología. No ocurre muy a menudo que usemos los mismos programas durante años enteros sin actualizaciones o modificaciones (por no hablar de miles de años), y de hecho, esos pequeños programas biológicos se desarrollaron hace decenas de miles de años, cuando las condiciones de vida eran muy distintas a las actuales. En aquel entonces no era demasiado importante para nuestra especie, desde un punto de vista biológico, mantener la salud una vez superada la edad de la reproducción. Y como la manifestación de ciertas infecciones virales o la del cáncer (por solo nombrar dos ejemplos de enfermedades cuyas posibilidades de aparecer aumentan con los años), está íntimamente relacionada con la expresión genética, la ribointerferencia promete convertirse en una tecnología clave en la lucha contra las enfermedades.

Nuevos genes de probeta.

Pero los científicos también están trabajando para incorporar nuevos genes al genoma, con lo que se solucionaría el problema de tener que ubicar la información genética de manera extremadamente precisa: un método viable es la introducción de la información genética In-Vitro, una técnica que garantiza que la información sea introducida en el lugar correspondiente. Luego de comprobar la efectividad del procedimiento, la célula modificada puede ser cultivada y reproducida in-vitro, luego de lo cual se le inyectan al paciente una gran cantidad de esas células, que por medio del torrente sanguíneo llegan al tejido correspondiente. Este tipo de terapia genética ya ha sido aplicada con éxito para curar hipertonía pulmonar en ratas, y en este momento está en la fase de experimentación con seres humanos.

Otro procedimiento importante es el cultivo de células propias, tejidos o hasta órganos enteros y su posterior implantación en el cuerpo. La gran ventaja de esta „clonación terapéutica“ consiste en la capacidad de fabricar tejidos y órganos desde nuestras propias células que, además, pueden ser rejuvenecidas. Ése es el objetivo de la medicina regenerativa que posibilitará, por ejemplo, la producción de células cardíacas tomando como base células de nuestra piel, que podrán ser inyectadas en el organismo y que con el tiempo llegarán a sustituir todas las células que conforman el corazón, suplantándolo con un órgano más joven que sin embargo, provendrá de nuestro propio ADN.

Al desarrollar de nuevos medicamentos, tradicionalmente los hombres intentamos encontrar sustancias que puedan curar malestares y enfermedades sin provocar efectos colaterales, aplicando un procedimiento que se parece mucho a aquel que ya usaban nuestros antepasados al inventar las herramientas: buscando en la naturaleza objetos que puedan utilizarse con un fin específico. Hoy, sin embargo, estamos comprendiendo (cada día un poco mejor) el funcionamiento de los procesos bioquímicos que desempeñan un papel importante en el surgimiento de las enfermedades y en el envejecimiento del ser humano, y podemos crear medicamentos que llevan a cabo su tarea a nivel molecular y de forma mucho más precisa. Las dimensiones y las posibilidades de esta tecnología son inconmensurables. El perfeccionamiento de nuestra biología, sin embargo, es solo uno de muchos pasos. De hecho, la biología nunca hubiera podido alcanzar lo que somos capaces de crear en condiciones de laboratorio, ahora que entendemos cada vez mejor los principios de funcionamiento biológicos.

Eso nos conduce a la „Revolución-N“: la revolución nanotecnológica. La nanotecnología alcanzará su madurez hacia el año 2020, pero hoy ya existen experimentos realmente impresionantes. Nadrian Seeman y William Sherman, de la Universidad de New York, crearon un nanobot capaz de caminar sobre dos piernas de tan solo diez nanómetros, probando así que las máquinas a escala nanométrica son capaces de llevar a cabo acciones precisas. La empresa norteamericana MicroCHIPS, por ejemplo, inventó un microscópico aparato controlado por ordenador, que se implanta bajo la piel y que libera cantidades infinitesimales de medicación que produce mezclando diferentes sustancias contenidas en nanodepósitos ubicados en su interior. Y hay una enorme cantidad de otros ejemplos.

En la década del 2020 estaremos en condiciones de producir todos los productos físicos que queramos utilizando materia prima barata, con la ayuda de la nanotecnología, y para ello haremos uso de procesos de información, rompiendo los límites de la biología y remplazando nuestro „Cuerpo Ver. 1.0“, por una notablemente mejorada versión „2.0“. La Killer-App de la Nanotecnología serán los „nanobots“, robots del tamaño de los glóbulos sanguíneos que viajarán por nuestras venas y arterias y eliminarán gérmenes patógenos, corregirán errores en el ADN y detendrán el proceso de envejecimiento.

Ya hemos dado los primeros pasos en esa dirección, remplazando en parte nuestros órganos y utilizando neuroimplantes para determinadas zonas del cerebro, que en sus versiones más modernas pueden ser reprogramados desde el exterior con nuevas versiones de software. Al final, todos nuestros órganos van a ser remplazados; los nanobots son capaces de introducir en nuestro torrente sanguíneo la cantidad óptima de nutrientes, hormonas y otras sustancias, y a la vez pueden eliminar los desperdicios y las sustancias tóxicas. El aparato digestivo podrá quedar reservado para los placeres culinarios en lugar de desgastarse con la digestión. (A fin de cuentas, también pudimos separar los aspectos comunicativos y divertidos del sexo de su función biológica).

Neuroimplantes para el cerebro y órganos para el cuerpo.

El cambio más profundo será el que traiga consigo la „Revolución-R“, la revolución robótica, generada por la IA-Fuerte o inteligencia artificial a nivel humano. Cientos de aplicaciones de la IA-Débil o inteligencia de las máquinas (que para la solución de problemas específicos son tanto o más poderosos que la inteligencia humana), ya inciden en nuestra infraestructura, cada vez que enviamos un mail o realizamos una llamada con el móvil, son algoritmos inteligentes los responsables de que la información llegue a destino. Hay programas inteligentes que analizan electrocardiogramas con la precisión de un médico, examinan cuadros médicos, despegan y aterrizan aviones, controlan sistemas automáticos de armamento, toman decisiones de inversión para fondos que manejan miles de millones de dólares y controlan procesos industriales. Hace apenas algunas décadas, todo esto aún eran proyectos de investigación.

En lo que respecta a la IA-Fuerte, para el año 2020 dispondremos de Hardware y Software que permitan la simulación de la inteligencia humana. Y continuaremos mejorando los métodos y aumentando la capacidad de almacenamiento y memoria para el procesamiento de la información y del conocimiento.

Por último, literalmente nos fusionaremos con los productos de nuestra tecnología. Esa fusión comenzará con nanobots funcionando en nuestros cuerpos y mentes, quienes nos mantendrán sanos y podrán recrear para nosotros una realidad virtual directa, hecha netamente de impulsos neuronales, posibilitarán la comunicación cerebro-a-cerebro por internet, y aumentarán considerablemente nuestra propia inteligencia. Hay que tener presente que la inteligencia artificial se duplica año tras año, mientras que la inteligencia biológica se encuentra prácticamente frenada. En la década del 2030, la parte no-biológica de nuestra inteligencia será dominante. A mediados de la década del 2040, esa parte de nuestra inteligencia será millones de veces más potente que la parte biológica. La inteligencia no-biológica comenzará a modificar su propio diseño y será capaz de mejorarse en ciclos cada vez más rápidos.

Estas no son visiones utópicas: las tecnologías GNR conllevan, cada una para sí, el riesgo de no poder cumplir con las expectativas que depositamos en ellas. Y existen riesgos: hoy mismo, ya estamos expustos al potencial riesgo de los virus biotecnológicos. La autoreproducción no-biológica será inherente a ciertos sistemas nanotecnológicos, lo cual también conlleva grandes peligros. Los riesgos existen, pero ese es tema para otro artículo. Solo diré qua la respuesta no debe ser la resingación. Cualquier intento por prohibir estas tecnologías no solo le robaría a la sociedad humana una oportunidad única, sino que las desplazaría a la ilegalidad, aumentando así el peligro.

Siempre me preguntan si luego de intervenciones tan drásticas en nuestra naturaleza, podremos seguir siendo considerados seres humanos. Evidentemente, quienes me hacen esa pregunta tienen una concepción del ser humano que requiere de ciertas limitaciones. Por el contrario, yo nos defino como una especie que intenta (y logra) superar sus limitaciones. Y como nuestra capacidad de ampliar nuestro propio horizonte también crece de forma exponencial, estoy seguro que nos encontramos ante un siglo que estará colmado de increíbles y profundos cambios.

Reflexivo, introvertido, taciturno y estoico; existencialista, constructivista y ateo.